Post by Julien ArlandisEffectivement, une image en noir et blanc codée sur 24 bits ne

contient que 8 bits d'informations utiles, c'est peu. À combien

faudrait il monter le nombre de bits par canal pour un résultat

acceptable, 12 bits, 16 bits ? Et surtout les capteurs numériques

peuvent monter à combien ?

NB: pour un gradient sur 4096 pixels, 12 bits suffisent a rendre chaque

valeur unique :-p

( en vrai c'est trop simpliste, e.g. si les valeurs extrêmes ne

recouvrent pas toute la dynamique ).

il faudrait retrouver les courbes de sensibilité humaine en condition

optimale, et repérer le gradient de sensibilité max ( vu qu'elle n'est

pas linéaire + pas meme encoding entre vision naturelle et artificielle

) mais de toute façon reste tj le cas + exigeant où tu veux pouvoir

faire des post-traitements, a commencer par corriger l'exposition.

les capteurs d'APN les plus pourris t'offrent 12 bits en raw depuis

longtemps. Pour les bons réflexes récents, je ne sais pas a combien où

on en est. Et si tu parle de télescopes professionnels, c'est encore

mieux. :-)

Cela dit ya ce que peut le capteur, et ya les limites dues a toutes les

sources de bruit ( thermique, optique, numérique ).

Post by Julien ArlandisMais ça c'est un problème du capteur lors de la prise de vue, ce n'est

pas le nombre de bits par couche qui va régler ce problème, c'est

surtout l'étendue de la plage dynamique des capteurs qu'il faudrait

améliorer.

c'est la meme chose !

certes l'appareil peut essayer de mieux regler l'exposition au min/max

de la photo, reste que souvent dans la meme photo tu peux avoir du

normal + tres sombre, ou normal + tres lumineux, ou les deux. Si tu

reparti tes 8 bits par channel sur 4 magnitudes de luminance en pratique

les quantum seront enormes. Il te faut + de bits ! la solution HDR du

pauvre actuelle etant de faire un bracketing rapide à 3 expositions (

façon de donner plus de bits, au risque du bouger ).

A defaut de capteurs 24 bits par channel, un truc malin serait peut etre

d'avoir 2 optiques a exposition differente, l'une basse resolution

servant à moduler l'exposition des pixels de l'autre.

Post by Julien ArlandisPost by robby- independamment de ça, n'avoir que 3 composants (et jamais assez

saturées ) fait qu'on ne peut interpoler qu'une petite partie du

domaine chromatique.

Pas compris, tu aurais un exemple ?

exemple ici:

Loading Image...

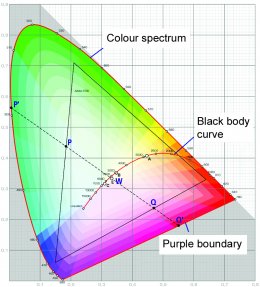

tu y vois le classique diagramme CIE représentant toutes les couleurs

perceptibles, et le triangle est la zone que tu peux obtenir en

combinant le résultat de 3 capteurs. 2 problemes: les 3 points du

triangles sont tj loin des bords perceptibles (jamais aussi saturés

qu'un pur rainbow), et de tt façon l'interpolation convexe dans le

triangle laisse des tas de régions pas couvertes ( un cyan numérique

n'est jamais aussi saturé qu'un bleu ou vert numériques ).

Pour des capteurs ou ecrans/imprimantes, tu peux parfois trouver des

docs montrant leur domaine dans le diagramme CIE.

Post by Julien ArlandisPost by robby en production on sait que le rendu du feu est souvent

problématique, par ex.

Quel est la nature du problème ? Au niveau de la compression ou de la

capture de l'image ?

capture et color space.

En synthese d'image, par ex, il faudrait autoriser des R,G,B negatifs

pour pouvoir sortir du triangle ( par ex RGB=(-.3,1,1) est un cyan plus

pur ), puis tout a la fin remapper tout ça dans un domaine affichable

(idéalement, selon techno de projection/impression ).

--

Fabrice